LAPGAN

之后看的论文应该还是会回到GAN这个方向,本篇说的是 Deep Generative Image Models using a Laplacian Pyramid of Adversarial Networks。 LAPGAN作为一个参数式生成模型,能够生成高质量的natural image。主要的做法是在Laplacian pyramid的框架下使用一系列的卷积网络,以一种从粗糙到精细的方式生成图片。

idea

利用natural image的multi-scale结构建立多个生成模型,每个生成模型根据Laplacian pyramid里面的scale抓取图片的信息,其中生成模型通过GAN来训练。有一句话作者多次强调也是本篇论文的核心思想:‘A key point in our work is giving up any ‘global’ notion of fidelity,and instead breaking the generation into plausible successive refinements’大概说的是不关注全局下的保真度,只关注连续优化情况下每一次生成的真实性。作者在论文的discussion部分还说了利用这种相似的思想来做简单网络的修改就能取得不错的效果。

structure

samples生成是以一种 coarse-to-fine 的方式,开始时是一些低频 residual 信息,下一层采样是根据 residual 对 band-pass 结构的作用,后面的采样采用同样方法,直到生成图片。换句话说:从粗糙级别,通过不断的上采样加上 residual 最后生成完整图像(这边比较难翻译,后面会慢慢解释)。

Laplacian Pyramid

Laplacian pyramid 是一种线性可逆图像表示方式,由一组 band-pass(带通)图像,间隔一个八度,加上一个低频 residual。先解释一下后面要用到的符号。$d(\cdot)$是对image I downsample 操作,$u(\cdot)$upsample 对应downsample。Gaussian pyramid $G(I)=[I_0,I_1,\dots,I_K], I_0=I$,$h_k$表示 Gaussian pyramid 中相邻level 之间的差值。

需要注意的是最后一层$h_K$不是difference image,而是低频residual。即$h_K=I_K$。那么$I_k$构造可循环成:

开始时$I_k=h_K$,重构目标是$I=I_0$,

LAPGAN

LAGAN 结合了CGAN(条件GAN)和Laplacian pyramid representation。在LAPGAN中,训练${G_0,\dots,G_k}$个卷积生成模型,分别对应着$h_k$的分布,结合生成器,上式可改写为:

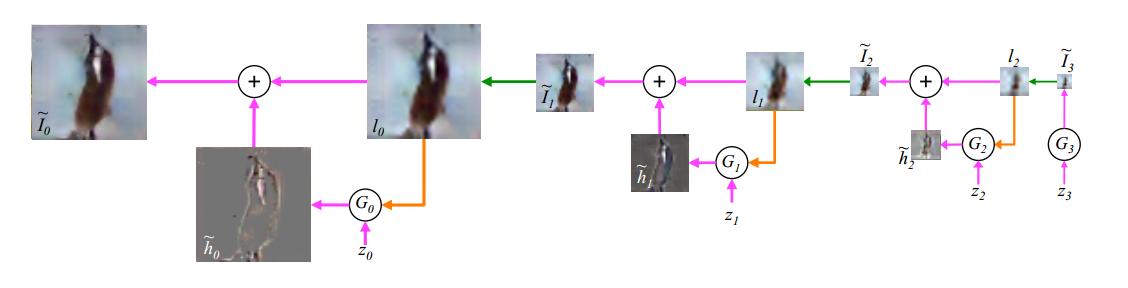

G表示生成器,一般令$I_{K+1}=0$,且对于最后一层G_K,它可以直接生成$I_K$:$I_K=G_K(z_K)$,有了上面的分析,贴出pyramid with 3的生成模型sample 图。

整个模型是如何训练的呢?论文中关于$h_k$的生成有两种方式(论文中说的是随机等概率选择一种):一种通过标准表达$h_k=G_k(I)-U(G_{k+1}(I))=I_k-u(I_{k+1})$,另外一种G_k生成:$\tilde{h_k}=G_k(z_k,u(I_{k+1}))$。对于判别器除了最后一个scale,因为采用的是CGAN训练,有两个参数,一个属upsampling之后的low-pass $l_k$,另一个参数由$l_k$通过上说的那种方式生成$h_k$或$\tilde{h_k}$分别对应的是real和generated,接着就是GAN的训练策咯先最大话再最小化(不展开)。接下来的每个scale,都按照此结构方式直到最后一层,最后一层使用标准的GAN即可,从下图可以看出整个网络训练过程。